Published : 05 Nov 2019 12:44 PM

Last Updated : 05 Nov 2019 12:44 PM

அறிவியல் சர்ச்சை: டீப்ஃபேக் - புதிய தொழில்நுட்ப பூதம்

சைபர் சிம்மன்

போலிச் செய்திகள், போலிப் படங்கள் பிரச்சினையெல்லாம் போதாது என்று போலி வீடியோக்களும் இணையத்தில் உலா வரத் தொடங்கியுள்ளன. இத்தகைய போலி வீடியோக்களை உருவாக்குவது மிக எளிதாக இருப்பதால், இவற்றால் ஏற்படக்கூடிய மோசமான பாதிப்புகள், சாமானியர்களில் இருந்து வல்லுநர்கள் வரை ஒருசேர மிரள வைத்துள்ளன.

இத்தகைய போலி வீடியோக்கள், தொழில்நுட்ப மொழியில் டீப்ஃபேக் (Deepfake) என்று வழங்கப்படுகின்றன. வீடியோக்களை அல்லாமல் படங்களை மட்டுமே போலியாகத் தயாரிக்க முடியும் என்ற நிலையே இத்தனை காலம் இருந்துவந்தது. இனிமேல் அப்படி நம்புவதற்கான சாத்தியங்கள் குறைவு!

புரட்டு வீடியோ

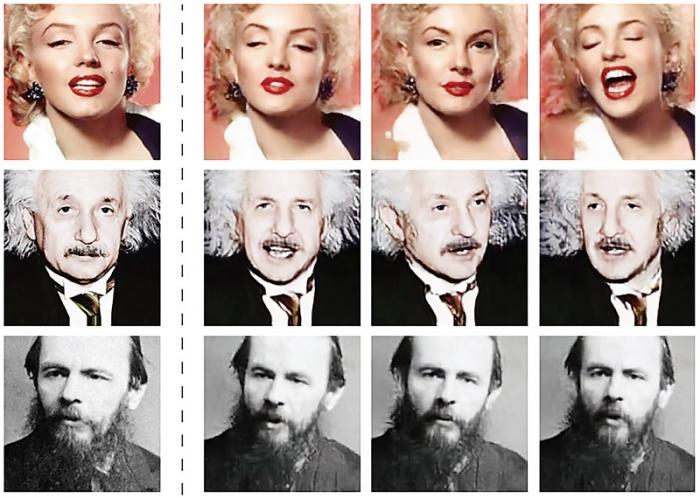

ஒரு வீடியோவில் உள்ள மனிதரின் முகத்துக்குப் பதிலாக வேறொருவரின் முகத்தைப் பொருத்துவது டீப்ஃபேக் தொழில்நுட்பத்தின் அடிப்படை. ஃபோட்டோஷாப் போன்ற மென்பொருட்களைக் கொண்டு, எப்படி ஒரு ஒளிப்படத்தில் உள்ள தலைக்கு பதிலாக வேறொருவர் தலையைப் பொருத்த முடிகிறதோ, அதேபோல் வீடியோவிலும், ஒருவருக்கு பதில் இன்னொருவர் தலையை பொருத்துவது போன்ற நுட்பமே இது. இவையெல்லாம் சம்பந்தப்பட்ட நபரின் சம்மதம் இல்லாமலேயே செய்யப்படும்.

இதன் மூலம் உண்மையான வீடியோவில் தோன்றும் நபர்கள், செய்யாதவற்றைச் செய்தது போல் போலியாக உருவாக்குவது சாத்தியமாகி இருக்கிறது; வீடியோக்களில் ஒட்டுவேலை செய்வது என்று எளிதாக இதைப் புரிந்துகொள்ளலாம். முகத்தை மட்டுமல்ல, இதே பாணியில் ஒலியையும் இணைத்து, வீடியோவில் ஒருவர் பேசாததையும் பேச வைப்பது சாத்தியம். இப்படித்தான் அமெரிக்க முன்னாள் அதிபர் ஒபாமா தோன்றும் வீடியோவை டீட்ஃபேக் மூலம் மாற்றி, அவர் சொல்லாததைச் சொல்ல வைத்தார்கள். ஃபேஸ்புக் நிறுவனர் ஸக்கர்பர்க் தோன்றுவதைப் போன்ற ஒரு போலி வீடியோவும் உருவாக்கப்பட்டுள்ளது.

தொழில்நுட்பக் கத்தி

டீப்ஃபேக் என்பது வெறும் வீடியோ ஒட்டு வேலை மட்டுமல்ல என்பதுதான் விஷயம். அது தொழில்நுட்ப நோக்கில் இன்னும் மேம்பட்டது, பெரும் ஆபத்தை உள்ளடக்கியது. ஏனென்றால், இந்த வீடியோ ஒட்டு வேலை என்பது வழக்கமான ஒட்டு வேலைகளில் இருந்து முற்றிலும் மாறுபட்டது.

மென்பொருளைக் கொண்டு ஒளிப்படங்களில் திருத்தம் செய்வதும் மாற்றி அமைப்பதும் இன்றைக்கு எளிது. இதேபோல வீடியோவிலும் கம்ப்யூட்டர் கிராபிக்ஸை கொண்டு மாற்றம் செய்யலாம். என்றாலும், இதற்கு அதிக பொருட்செலவும், மிகுந்த மெனக்கெடலும் தேவை. ஆற்றல்மிக்க கணினி மென்பொருள்களைக் கொண்டு, நூற்றுக்கணக்கான மணி நேர உழைப்புக்குப் பிறகே, வீடியோவை மாற்றி அமைப்பது சாத்தியமாக இருந்தது. அப்போதும்கூட, இறுதி உருவாக்கம் எந்த அளவுக்கு உண்மையானதாக இருக்கும் என்ற நிச்சயம் கிடையாது.

இந்த இடத்தில்தான் டீப்ஃபேக் நுட்பம் வருகிறது. இங்கு நிகழ்வது கணினி வழியிலான மறுஉருவாக்கம். எனவே, உருவாக்கப்படும் போலி, அசலைப் போலவே இருப்பதற்கான சாத்தியம் அதிகம் என்பதுடன், இரண்டுக்கும் இடையிலான வேறுபாட்டைக் கண்டுபிடிப்பது மிகவும் கடினம். எனவேதான், இல்லாத ஒன்றை இருப்பதைப் போல் காண்பிக்கும் வகையில் வீடியோவின் உள்ளடக்கத்தை மாற்றியமைக்கும் நுட்பமாக டீப்ஃபேக் விளங்குகிறது. இது எப்படி சாத்தியம்? இந்த கேள்விக்கான பதில், ஏ.ஐ. (A.I) எனப்படும் செயற்கை நுண்ணறிவில் அடங்கியிருக்கிறது.

இயந்திரக் கற்றல்

செயற்கை நுண்ணறிவின் உட்பிரிவுகளில் ஒன்றான, இயந்திரக் கற்றலில் வளரும் துறையாகக் கருதப்படும், ஜெனேரேட்டிவ் அட்வர்சரியல் நெட்வொர்க் (கான் - GAN), இவ்வாறு போலி வீடியோக்களை உருவாக்கப் பயன்படுத்தப்படுகிறது. ஏற்கெனவே பார்த்ததைப் போல், டீப்ஃபேக்கில் வீடியோக்கள் ஒட்டப்படுவதில்லை. புதிதாகவும் அதேநேரம் மிகவும் நுட்பமாகவும் உருவாக்கப்படுகின்றன. இது போன்ற வெளிப்பாடு தேவை என்ற குறிப்புடன், அதற்கான மூலத் தரவுகளைக் கொடுத்துவிட்டால் போதும். அந்த தரவுகளில் இருந்து நாம் எதிர்பார்க்கும் முடிவுக்கு நெருக்கமான ஒன்றை, ‘கான்' மென்பொருள் உருவாக்கித் தர முயற்சிக்கும்.

இது சோதனை - சரிபார்த்தல் முறையில் நிகழ்கிறது. அதாவது, மென்பொருள் இரண்டு பகுதியாகப் பிரிந்து செயல்படும். முதல் பகுதி ஒன்றை உருவாக்கும்; இரண்டாம் பகுதி அதைச் சரிபார்த்து, விரும்பிய வகையில் இருக்கிறதா என்று கணித்துச் சொல்லும். முதல் பகுதி உருவாக்க, இரண்டாம் பகுதி அதில் குறைகளைக் கண்டுபிடித்துக்கொண்டே இருக்கும். அதற்கேற்ப முதல் பகுதி தனது முயற்சியை மேம்படுத்தி, உருவாக்கத்தை மெருகேற்றிக்கொண்டே இருக்கும். இப்படி திரும்பத் திரும்பச் செய்வதன் விளைவாக, முடிவு மேம்பட்டதாக அமையும்.

கண்ணை நம்பாதே

‘கான்' மென்பொருளின் துணையோடு போலி வீடியோக்கள் இப்படித்தான் உருவாக்கப்படுகின்றன. ஒரு வீடியோவை கொடுத்து, அதில் யாருடைய உருவம் தோன்ற வேண்டும் எனத் தெரிவிக்க வேண்டும். அதை இலக்காக வைத்துக்கொண்டு மூல வீடியோவின் அம்சங்களை அலசி ஆராய்ந்து, அதிலிருந்து தொடங்கி நாம் கேட்கும் முகத்தை மென்பொருள் வந்தடைகிறது. இதற்காக மென்பொருள் வீடியோ காட்சியில் இருந்து மனித முகத்தின் ஆயிரக்கணக்கான படங்களைச் சலித்து எடுத்து அவற்றை அலசி, அவற்றின் அடிப்படை அம்சங்களைக் கொண்டு, கொடுக்கப்பட்ட உருவத்தை மாற்றித் தருகிறது.

இந்த உருமாற்றம் சரியாக வருகிறதா இல்லையா என மென்பொருள் தொடர்ந்து சரிபார்த்துக்கொண்டே இருப்பதால், அதன் இறுதி வடிவம் உண்மையானது போலவே தோன்றும். ஆக, இந்த மென்பொருளிடம் ஒரு ஒளிப்படத்தை கொடுத்து, அதில் தோன்றும் நபரை வேறு ஒரு வீடியோவில் பொருத்தித் தருமாறு கூறினால், அதை துல்லியமாக நிறைவேற்றி புதிய வீடியோவை உருவாக்கித் தந்துவிடும்.

வில்லங்கமும் விபரீதமும்

டீப்ஃபேக் நுட்பத்தைப் பயன்படுத்தி உருவாகப்படும் வீடியோக்களில் பெரும்பாலானவை ஆபாச ரகங்கள் என்றாலும், அரசியல் நோக்கிலும் போலி வீடியோக்கள் உருவாக்கப்படுகின்றன. வீடியோ வடிவில் போலிச் செய்திகளை உருவாக்குவதும் சாத்தியமே. யார் வேண்டுமானாலும் போலி வீடியோக்களை உருவாக்கி, விஷமப் பிரச்சாரத்தில் ஈடுபடலாம். இதனால் எண்ணற்ற வில்லங்கங்களும் விபரீதங்களும் உண்டாகலாம். இப்போதேகூட போலி விடியோக்களை உருவாக்குவது சாத்தியம் என்பதால், நீதிமன்றங்களில் வீடியோவை ஆதாரமாக எடுத்துக்கொள்ளும் தன்மை கேள்விக்குறியாகி இருக்கிறது. வீடியோ ஆதாரம் உண்மை எனும் நிலை மாறி, வீடியோ உண்மையா என்ற நிலை உருவாகி இருக்கிறது.

வெளிச்சத்துக்கு வந்தது எப்படி?

எதற்கு இப்படி ஒரு வில்லங்கத் தொழில்நுட்பம் என்று கேட்கலாம். உண்மையில், போலி வீடியோக்களுக்காக இந்த நுட்பம் உருவாக்கப்படவில்லை. முகமறிதல் நுட்பம் (Facial recognition) தொடர்பான ஆய்வின் ஒரு பகுதியாக இது உருவானது. செயற்கை நுண்ணறிவு தொடர்பான ஆய்வு பல திசைகளில் மேற்கொள்ளப்பட்டு வரும் நிலையில், மனித முகங்களைக் கணினியைக் கொண்டு அறிவது தொடர்பான திசையிலும் தீவிர முயற்சி மேற்கொள்ளப்பட்டுவருகிறது. பொழுதுபோக்கு, மருத்துவம் உள்ளிட்ட துறைகளில் இது நல்லவிதமாகப் பயன்படுத்தப்படலாம்.

அதேநேரத்தில் கண்காணிப்பு நோக்கில் அரசாலும் இது பயன்படுத்தப்படுவதற்கான சாத்தியங்கள் அதிகளவில் உள்ளன. இதனிடையே, தொழில்நுட்ப ஆர்வம் கொண்ட கணினி ஆர்வலர்கள் சிலர், பொதுவெளியில் பரவிய வீடியோ உருவாக்க மென்பொருள் நுட்பத்தை ஆய்வு நோக்கில் பயன்படுத்தி, ஆபாசப் போலி வீடியோக்களை உருவாக்கி உலவவிட்டனர். சமூக வலைதளமான ரெட்டிட்-ல் இது தொடர்பாக அமைக்கப்பட்ட குழுவில், நட்சத்திரங்களின் போலி வீடியோக்கள் வலம்வந்தன. இந்த நிகழ்வுகளே போலி வீடியோ விவகாரத்தை வெளிச்சத்துக்குக் கொண்டுவந்தன.

ரெட்டிட் குழுவில், போலி வீடியோக்களைப் பகிர்ந்துகொண்ட நபர், ‘டீப்ஃபேக்ஸ்’ எனும் பெயரில் செயல்பட்டு வந்தார். இந்த பெயரே போலி வீடியோக்களைக் குறிக்கப் பயன்படுத்தப்படலானது. அதேநேரத்தில், இதன் பின்னே உள்ள அடிப்படை நுட்பம் ‘டீப் லேர்னிங்’ எனும் ஆழ் கற்றலை மையமாக கொண்டுள்ளதால், இதன் மூலம் போலி (ஃபேக்) வீடியோக்கள் உருவாக்கப்படுவதை குறிக்கும் வகையிலும், டீப்ஃபேக் எனும் பதம் பயன்படுத்தப்படுகிறது.

இந்த வில்லங்கம் போதாது என்று, இத்தகைய வீடியோக்களை எவரும் மிக எளிதாக உருவாக்கும் வகையில் ‘ஃபேக் ஆப்’ எனும் செயலியும் உருவாக்கப்பட்டது. இப்போது டீப்ஃபேக் போலி வீடியோ பூதத்தை எப்படி அடக்குவது எனத் தெரியாமல் இணைய உலகம் திணறிக்கொண்டிருக்கிறது.

கட்டுரையாளர்

தொடர்புக்கு: enarasimhan@gmail.comஅறிவியல் சர்ச்சை

FOLLOW US

Sign up to receive our newsletter in your inbox every day!

WRITE A COMMENT